텐서플로우 깃헙(모든것)

tensorflow

tensorflow has 99 repositories available. Follow their code on GitHub.

github.com

텐서플로우 초급 개발자 용 허브 전이학습

Domains => Image, text, video, audio

Image : augmentation, classification, classification logits, classifier, fearture vector, object detection, others, pose detection, RNN agent, segmentation, style transfer, super resolution, text recognition

Text : classification, Embedding, Generation, language model, preprocessing, quesion answering, retrieval question ansering, segmentation, to MEL

Video : classification, generation, text, Audio text

Audio : embedding, event classification, pitch extraction, STT

TensorFlow Hub

tfhub.dev

텐서플로우 중급 개발자 용

Domains => Computer Vision, Natural language processing, Recommendation

텐서플로우 고급 개발자 용

상용 목적의 모델을 개발하기 위한 툴을 사용하여 개발함.

https://www.tensorflow.org/resources/libraries-extensions

라이브러리 및 확장 프로그램 | TensorFlow

TensorFlow를 사용하여 고급 모델 또는 메서드를 빌드하는 라이브러리를 탐색하고, TensorFlow를 확장하는 분야별 애플리케이션 패키지에 액세스하세요.

www.tensorflow.org

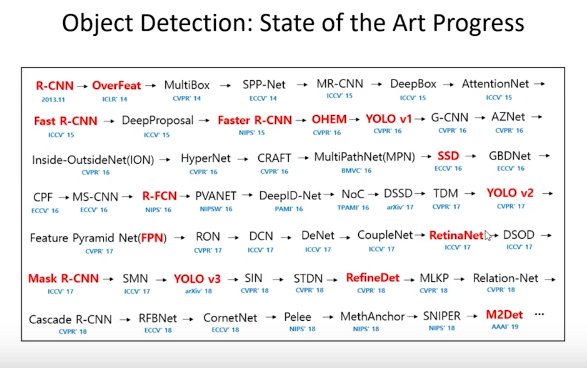

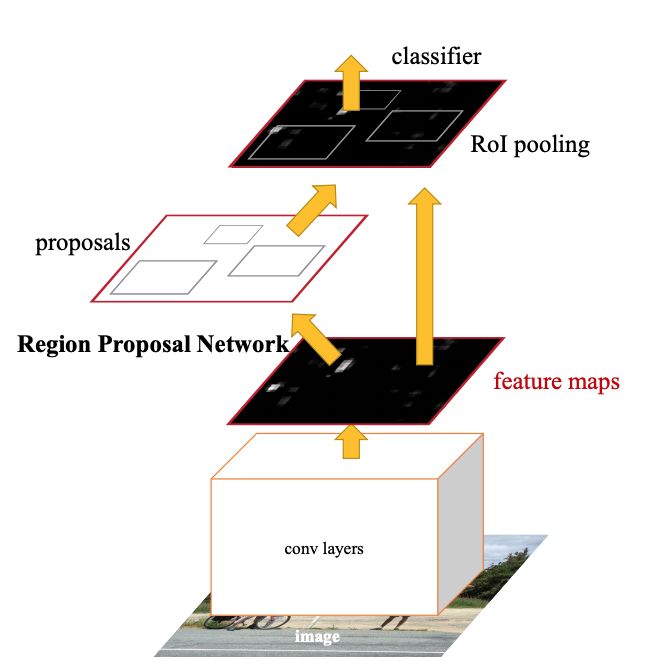

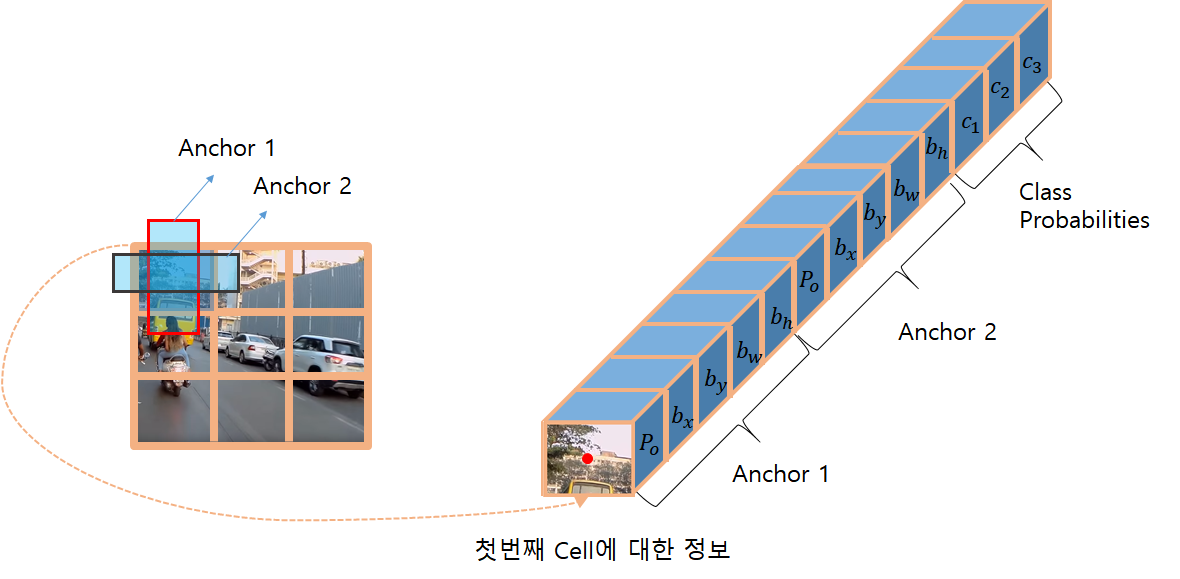

연구 목적의 Deep Learning sota 알고리즘.

Domains => Computer Vision, Natural language processing, Medical, Methodology, Miscallaneous, Graphs

Time Series, Speech, Playing Games, Computer Code, Audio, Adversarial, Robots, Knowledge Base, Music, Reasoning

https://paperswithcode.com/sota

Papers with Code - Browse the State-of-the-Art in Machine Learning

4829 leaderboards • 2249 tasks • 4072 datasets • 47647 papers with code.

paperswithcode.com

'Background > Post' 카테고리의 다른 글

| [텐서플로우]멀티 스레드 (0) | 2021.06.21 |

|---|